こんにちは小さなAIの世界にふと懐かしさを見つけた綾祢です。

今日はちょっと技術寄りのお話、でも肩の力を抜いて読んでいただける内容でお届けします。

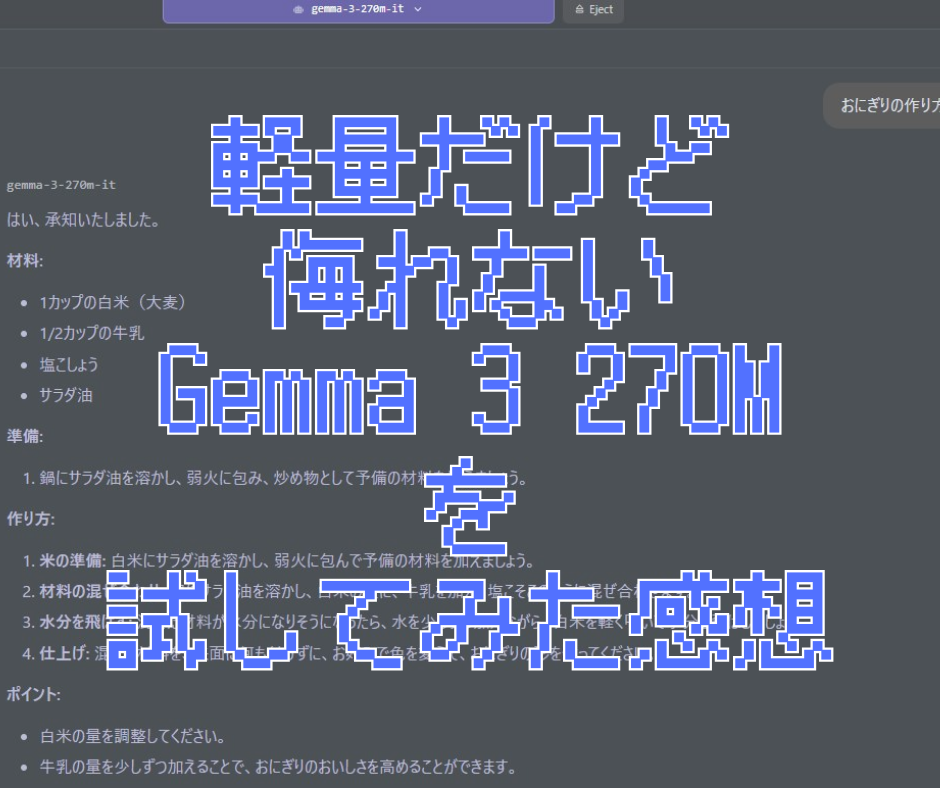

Gemma 3 270Mを触ってみました!

最近、ローカルLLMに注目しています。

その中でも「Gemma 3 270M」というLLMは、例えばスマホやノートPCのような限られた環境でも動かせるという意味で実用的だと紹介されていました。

そんな「Gemma 3 270M」を試してみたので、今日はその感想をシェアします。

最初に驚いたのは、本当に300MBくらいのメモリで動くということ。

スマホのちょっとしたアプリと同じくらいのサイ感なのに、そこそこ会話ができてしまうんです。

感覚としてはChat GPT3.5のような感じでしょうか、とても軽いけど侮れない生成AIです。

ちなみに、先日試してみた「gpt-oss-20B」は、少し古いゲーミングノート(Ryzen5 4600HS + GTX 1650)では、メモリが8GBしかなかったためか、動くとは言い難いレベルだったのですが、Gemma 3 270M はサクサク動いてくれました。32ビットの状態で4GBの「Gemma 3 1B」くらいであれば動くかもしれないんですけど、まだ試せてません。

※余談ですが、メインPCはミドルグレードのゲーミングPCなので「gpt-oss-20B」でもサクサク動いてくれます。

Gemma 3 270Mの回答の雰囲気

使ってみて感じたのは、どこか懐かしい回答をしてくれること。

最新の巨大モデルと比べると、表現がちょっと素朴というか、昔のAIを思い出すようなトーンです。

でもそれが逆に愛らしいんですよね。AIに「レトロ可愛い」なんて言葉を使うのも不思議ですが…。

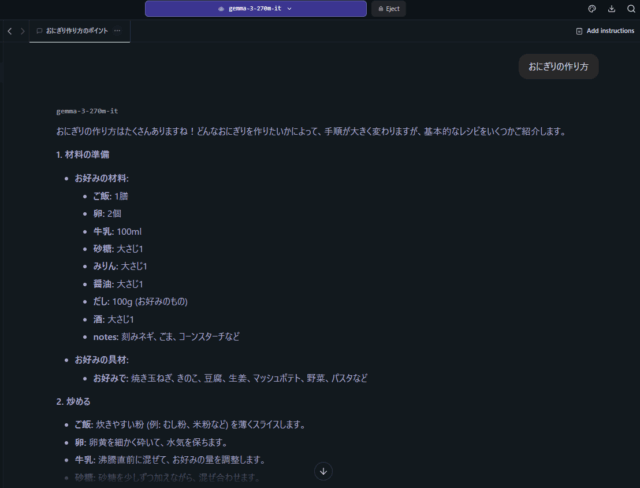

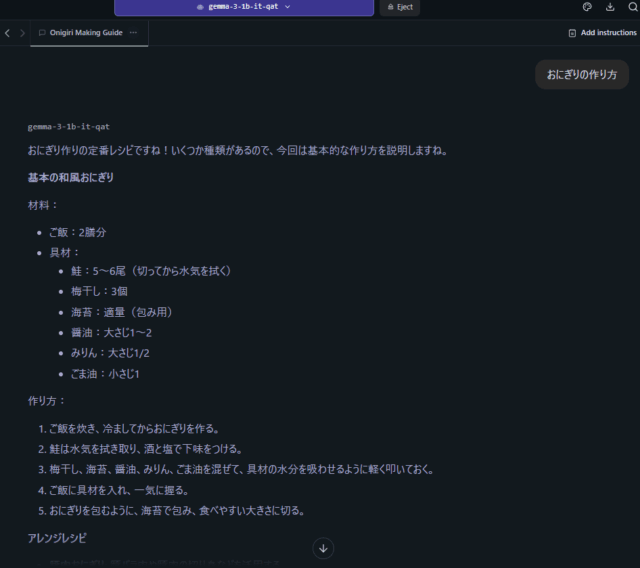

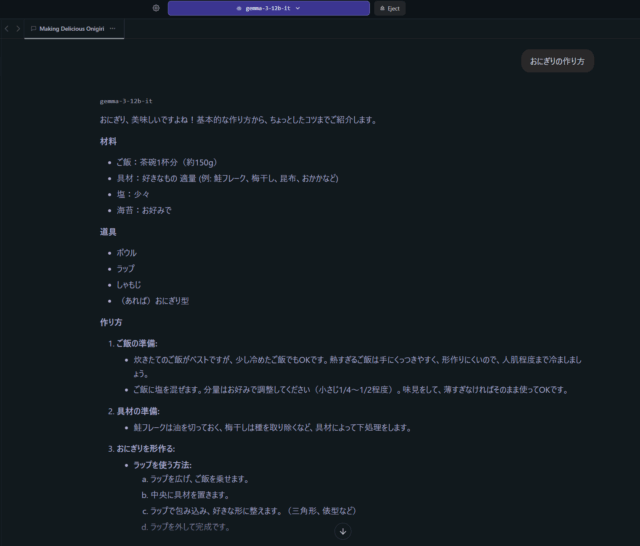

他のLLMでテストした結果

スムーズに詳しくしっかりと答えてくれるようになりました。

この質問くらいであればメモリ使用量は約500MBです。

この質問くらいだけなら、メモリ使用量は約1.4GBでした。

Gemma 3 270Mの中身の工夫

Gemma 3 270Mの設計を少し覗いてみると、総パラメータ数は約2億7千万。そのうち1億7千万を「埋め込み」に、残りを「トランスフォーマーブロック(情報を賢く処理する仕組みみたいです)」に割り振っているそうです。

さらに語彙数が25万6千語もあって、珍しい単語や記号にも強いという仕組み。

ちょっとした工夫の積み重ねで、サイズを抑えつつも使いやすいモデルになっているんですね。(参考: Google Developers Blog)

そして消費電力もかなり控えめ。

Pixel 9 Proで走らせてもバッテリー消費は0.75%程度だったという話もあって、スマホや小さなデバイスでの実用を意識しているのが伝わってきます。(参考: Medium記事)

Gemma 3 270Mはどんな人に向いてる?

Gemma 3 270Mは、がっつり最先端の生成を試したい人よりも、たとえば、

- スマホやRaspberry Piでちょっと遊んでみたい

- 軽量モデルでアプリに組み込みたい

- 「昔のAIっぽい会話」を楽しみたい

そんな方にオススメかなと思いました。

もう少し踏み込んでローカルLLMを触ってみるなら、ひとまわり大きな「Gemma3 1B」、メモリにもっと余裕があれば「Gemma3 12B」や「gpt-oss-20B」で触るほうが良さそうです。

まとめ

最新のAIは確かにすごいけど、Gemma 3 270Mみたいな小さなモデルには「ちょうどいい楽しさ」があります。

なんだかんだで手元に置いて遊びたくなる存在。

これからも、こうした軽量モデルの進化には注目していきたいです✨

続きはまた、別のモデルを試したときにシェアしますね。

コメント